موسسه Research 451 در گزارش جدید خود تاکید دارد تراکم رکهای مراکزداده در حال افزایش است و شرکتهای فناوری نیز انتظار دارند این روند ادامه پیدا کند.

همیشه افزایش تراکم رکها در صنعت شبکه و مرکزداده مطرح بوده است و شاهد افزایش تجهیزات نصب شده در یک رک استاندارد بودیم ولی در سالهای اخیر به طور واضح این تراکم بیشتر شده است. تا همین اواخر، متوسط تراکم رکها، ۵ کیلووات در هر رک بوده است ولی اکنون این پارامتر تغییر کرده و افزایش قابل توجهی داشته است.

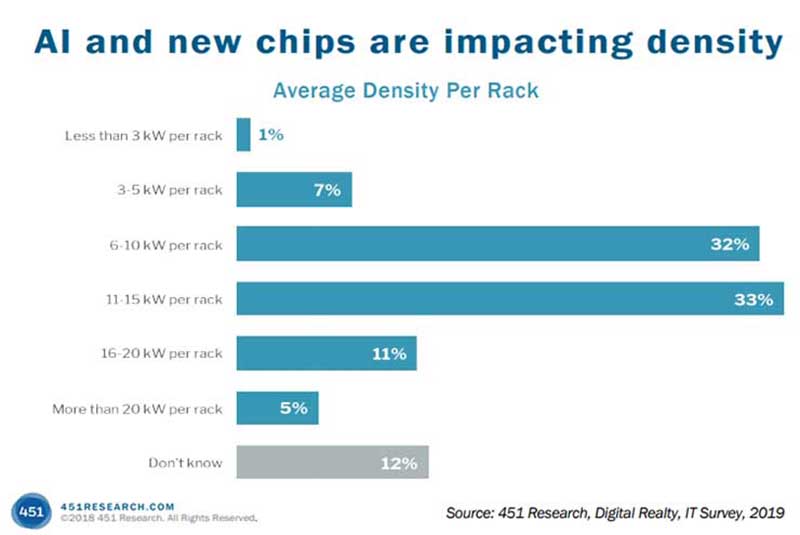

براساس نظرسنجی موسسه Research 451 از ۷۵۰ شرکت بزرگ و اینترپرایس، ۴۵ درصد آنها گفتهاند انتظار دارند متوسط تراکم رکها در سال آینده به ۱۱ کیلووات برای هر رک برسد و شاید هم بیشتر!

این یک تغییر بسیار بزرگ نسبت به نظرسنجی انجام شده در سال ۲۰۱۴ است که فقط ۱۸ درصد پاسخدهندهها از ۴۵۱ شرکت انتظار داشتند متوسط تراکم رکها به بیش از ۱۰ کیلووات برسد.

پس، در ۵ سال گذشته چه چیزی تغییر کرده است که شرکتها دوست دارند در هر رک تجهیزات بیشتری نصب کنند یا رکهای جدید با تراکم بالاتری عرضه شوند؟

نظرسنجی موسسه ۴۵۱ در سال ۲۰۱۹: هوش مصنوعی و تراشههای جدید تراکم رکها را تحت تاثیر قرار دادند.

یک عامل مهم در افزایش تراکم رکها، افزایش دادههای هوش مصنوعی است. سختافزارهای جدید باید قدرت محاسباتی بالاتری برای مدیریت و پردازش بارهای ترافیکی مصارف هوش مصنوعی و یادگیری ماشینی داشته باشند یا شرکتها تعداد تجهیزات بیشتری در یک رک برای رسیدن به یک قدرت محاسباتی مورد نیاز نصب کنند. افزایش قدرت محاسباتی با افزایش مصرف انرژی برق توسط سرورها و سیستمهای ذخیرهسازی و همچنین تولید گرمای بیشتر در یک رک همراه است.

وقتی از گرمای بیشتر صحبت میکنیم؛ پای سیستمهای سرمایشی نیز به میان میآید. اپراتورهای مراکزداده دائما با چالش خنکسازی سرورها و تجهیزات روبرو هستند و باید استراتژیها و طرحهای جدیدی برای کاهش دمای رکها و تجهیزات درون آنها به کار بگیرند. از جمله رویکردهای جدید در حوزه سیستمهای سرمایشی میتواند استفاده از خنککنندههای مایع باشد.

کاربران نهایی، رکهای متراکمتر میخواهند

مراکزداده در سالهای جدید به محیطهای HPC (سرنام High-Performance Computing) نزدیک شدند.

تراشهها و اپلیکیشنهای جدید هوش مصنوعی به انرژی بسیار بیشتری برای اجرا نیاز دارند. در یک رک دهها و صدها تراشه استفاده میشود و هنگامی که هر تراشه هوش مصنوعی مصرف انرژی بالاتری نسبت به تراشههای سنتی داشته باشد؛ طبیعی است که تراکم رک و مرکزداده تحت تاثیر قرار میگیرد. این روند همچنان ادامه دارد و هر سال سرعت بیشتری میگیرد و نمیتوان آن را متوقف کرد.

موسسه Research 451 در گزارش نظرسنجی دیگری به نام The Infrastructure Imperative میگوید نزدیک به ۵۴ درصد پاسخدهندگان گفتند از زیرساختهای HPC استفاده میکنند که قدرت محاسباتی عظیمی را در یک فضای کوچک فراهم میکند. بیش از ۵۰ درصد این افراد هم گفتهاند از زیرساختهای همگرا در محل شرکتشان استفاده میکنند.

نظرسنجی AFCOM در سال ۲۰۱۹ نیز تایید میکند گرایش به سوی رکهای با تراکم بالاتر در سالهای اخیر افزایش پیدا کرده است. در این گزارش هم ۲۷ درصد پاسخدهندهها گفتهاند دنبال استقرار راهکارهای با قدرت محاسباتی بالا (HPC) هستند، و ۳۹ درصد پیشبینی کردهاند با استفاده از زیرساختها و معماریهای همگرا میتوانند تراکم رکهای سنتی را افزایش دهند.

اما کاربران نهایی صنعت مرکزداده دقیقا چه انتظاری از رکهای آینده دارند؟ از نظر آنها یک رک باید به طور متوسط چه تراکم و ظرفیتی داشته باشد؟ موسسه ۴۵۱ در نظرسنجی خود به این نتیجه رسیده است که رکهای با تراکم ۷ کیلووات به بالا از نظر مشتریان پذیرفته است. در نظرسنجی AFCOM از این مقدار بالاتر هم گفته شده است.

این وضعیت صنعت مرکزداده را به چالش اساسی میکشاند. چون برخی از مراکزداده دیگر نمیتوانند از تراکم رکهای داخلی خود پشتیبانی کنند و به سراغ تغییر و اصلاح سیستمهای سرمایشی یا گزینههای با تراکم بالاتر میروند. سرویسدهندههای ابری هم باید استراتژیهای طراحی و عملیاتی خود را تغییر دهند تا به نیازهای با تراکم بالا پاسخگو باشند.

فرصت نابی برای سیستم سرمایشی مایع

یکی از روشهای رفتن به سوی رکهای با تراکم بالاتر، تغییر استراتژی سیستمهای سرمایشی است. سیستمهای سرمایشی مبتنی بر مایع میتوانند یک گزینه مطلوب در این وضعیت باشند ولی هنوز بسیاری از شرکتها با احتیاط برخورد کرده و بهویژه در مقیاسهای بزرگ کاملا دست به عصا هستند. بیشتر سرورها و رکها برای سیستمهای سرمایشی مبتنی بر هوا و باد طراحی شدهاند ولی در بازار میتوان شرکتهایی را یافت که روی راهکارهای سیستمهای سرمایشی مایع برای محیطهای با تراکم بالا تمرکز دارند. برای مثال میتوان شرکتهای Switch، Aligned Energy و ScaleMatrix را نام برد که کاملا رکها و تجهیزات شبکه را درون سیلوهای مایع قرار میدهند. برخی شرکتهای دیگر مانند Colovore که در ایالت سانتا کلارا مستقر است یا تجهیزات شرکت لینکدین در مرکزداده STACK Infrastructure پورتلند اورگان دارای رکهایی با دربهای مجهز به چیلرهای آبی هستند.

سیستم سرمایشی مایع شرکت DownUnder GeoSolutions برای محیطهای HPC

گوگل معماری سختافزارهای مرکزداده خود را برای استفاده از سیستمهای سرمایشی مایع تغییر داده است تا بتواند به تراکم مورد انتظار در هوش مصنوعی برسد. خردهفروشی علیبابا و دیگر شرکتهای غول چینی هم به سوی راهکارهای سرمایشی مایع حرکت کردند. مایکروسافت اخیرا اعلام کرده است در حال آزمایش یک سیستم سرمایشی مایع برای سرویس ابری Azure خود است. غول ردموند فعلا عکس و خبری از این سیستم منتشر نکرده و این پروژه را به صورت مخفیانه و محرمانه پیش میبرد. فیسبوک، دیگر بازیگر بزرگ صنعت مرکزداده به جای سیستم سرمایشی، سراغ یک راهکار جدید مبتنی بر سرمایش هوایی برای محیطهای گرمتر خود رفته است.

سالها است که متخصصان دنیای مرکزداده به دنبال روشهایی برای استفاده سریعتر و سادهتر از سیستمهای سرمایشی مایع هستند. هر روز فناوریهای جدید به قدرت محاسباتی بیشتری نیاز دارند و این یعنی مصرف انرژی بیشتر و تولید گرمای بالاتر. یک مزیت بزرگ سیستمهای سرمایشی، مصرف بهینه انرژی و تمرکز روی سختافزار و تجهیزات نصب شده در یک محیط کوچک است. راهکارهای این نوع سیستمهای سرمایشی غالبا برای اتاقهای سرور و اتاقهای کوچک دارای چندین رک و سرور هستند. هزینه سیستمهای سرمایشی مایع بیشتر از سیستمهای سرمایشی هوا است ولی اجازه میدهد تراکم رکها و تجهیزات نصب شده در یک فضای کوچک بالاتر بروند.

سختافزارهای جدید مرزها را میشکنند

در بخش تولیدکنندههای سختافزار هم حرکتهایی به سوی طراحی و ساخت انواع پردازندههای مرکزی، بُردها و تراشههای گرافیکی با قدرت محاسباتی بالاتر برای محیطهای HPC شاهد هستیم. اینتل همیشه سعی کرده موقعیت برتر خود در فضاهای محاسبات سازمانی را حفظ کند و هر سال سختافزارهایی با قدرت محاسباتی بالاتر ولی ابعاد کوچکتر و مصرف انرژی کمتر معرفی میکند. شرکتهایی مانند انویدیا هم به طور آشکارا تراشههای GPU برای HPC و ابررایانهها ساختند. این سختافزارها در ابعادی به اندازه یک سرور سنتی، قدرت محاسباتی چند ده برابر ارائه میدهند یا اینکه مبتنی بر معماری سرورهای کم مصرف ARM هستند تا به روشی دیگر جلوی افزایش گرما در محیطهای با تراکم بالا را بگیرند.

معماری استارتاپ Groq با پردازندههای Tensor Streaming Processor

پیشبینی میشود در آینده بزرگترین چالش در طراحی مراکزداده، تراشههای هوش مصنوعی ساخته شده توسط شرکتهای سختافزاری مختلف باشد. هریک از این تراشهها با یک فناوری و مجموعهای از رویکردها ساخته شده و در حالیکه فوقالعاده قدرتمند هستند؛ عوامل جدیدی را به محیط تحمیل میکنند. مثلا، شرکت استارتاپی به نام Groq اعلام کرده در معماری جدید Tensor Streaming Processor خود به ظرفیت کارایی PetaOp/s1 روی یک تراشه رسیده است؛ یعنی یک کوآدریلیون عملیات در هر ثانیه. این استارتاپ توسط مهندسانی راهاندازی شده است که به گوگل در ساخت تراشههای هوش مصنوعی Tensor Processing Unit کمک کردند. تراشه جدید ساخت Groq از مدلهای یادگیری ماشینی سنتی و جدید پشتیبانی کرده و برای هر دو معماری x86 و غیر از آن کار میکند. همینطور استارتاپهایی مانند NUVIA و Cerebras هستند که با پشتیبانی مخفیانه یا آشکارای شرکتهای بزرگ فناوری و دره سیلیکون ایالات متحده، روی معماری و طراحی تراشههای AI جدید کار میکنند. استارتاپ Cerebras یک تراشه به نام WSE (سرنام Wafer-Scale Engine) ساخته است که تقریبا ۹ اینچ عرض دارد و بزرگترین تراشه گرافیکی موجود در جهان است ولی مرزهای محاسبات را میشکند و البته ۱۵ کیلووات مصرف انرژی دارد.

آینده چگونه است؟

به هر حال، کاربردهای هوش مصنوعی و تراشههای AI در حال افزایش است و نمیتوان این مسیر را متوقف کرد. صنعت مرکزداده ناگزیر است به سوی سختافزارها، تجهیزات رک و سرور، سیستمهای سرمایشی و فناوریهایی برود که ظرفیت تحمل تراکم بالاتری در یک فضای کوچکتر را داشته باشند. افزایش تقاضا برای محاسبات در لبه شبکه و میکرومراکزداده هم این وضعیت را پیچیدهتر میکند. سازندههای مراکزداده باید سختافزارهای جدیدتری به کار بگیرند و سراغ سیستمهای سرمایشی نوینی بروند. این معادله هم فرصتهای تازه و هم چالشهای بزرگی ایجاد خواهد کرد.

دیدگاه خود را بنویسید