در سالهای اخیر، استفاده از چتباتهای هوش مصنوعی مانند ChatGPT برای کاربردهای مختلفی مثل حل مسايل ریاضی، ترجمهی متون، تولید محتوا، و حتی تهیه فهرستی از غذاها یا دستور آشپزی افزایش یافته است.

اما برخی افراد از این چتباتها به عنوان درمانگر یا تراپیست استفاده میکنند و نتایج خود را در شبکههای اجتماعی با دیگر کاربران به اشتراک میگذارند. این افراد به جای مراجعه به روان پزشک، پرسشها و مشکلات سلامت روان خود را با چت جیپیتی در میان میگذارند و جلسات روان درمانی رایگان یا مشاورههای درمانی راحت ِ بدون اتلاف وقت و هزینه، دریافت میکنند.

یک کاربر تیکتاک تا آنجا پیش میرود که تراپیست خود را با ربات هوش مصنوعی جایگزین کرده و اعلام میکند: «امروز به طور رسمی، جلسات درمانی خود را تعطیل کردم و از بهترین جایگزین آنها، یعنی ChatGPT استفاده خواهم کرد.»

این فعالیتها و تصمیمها برای افرادی که در حوزهی روان درمانی و تراپی، مشغول به فعالیت هستند؛ نگرانکننده است اما آیا آنها نگران از دست دادن شغل و درآمد خود هستند؟

دکتر «بروس آرنو»، استاد گروه روانپزشکی و روانشناس ارشد دانشگاه استنفود در این باره میگوید: «به این موضوع شک و تردید داشته باشید. چتباتهای هوش مصنوعی جایگزینی برای درمان، رواندرمانی یا هر نوع مداخلهی روانپزشکی نیستند و برای این هدف نیز ساخته نشدهاند. البته، زیاد دور نیست زمانی که آنها برای چنین کارهایی آماده باشند اما ما دقیقا نمیدانیم آیا هرگز این اتفاق میافتد یا خیر!»

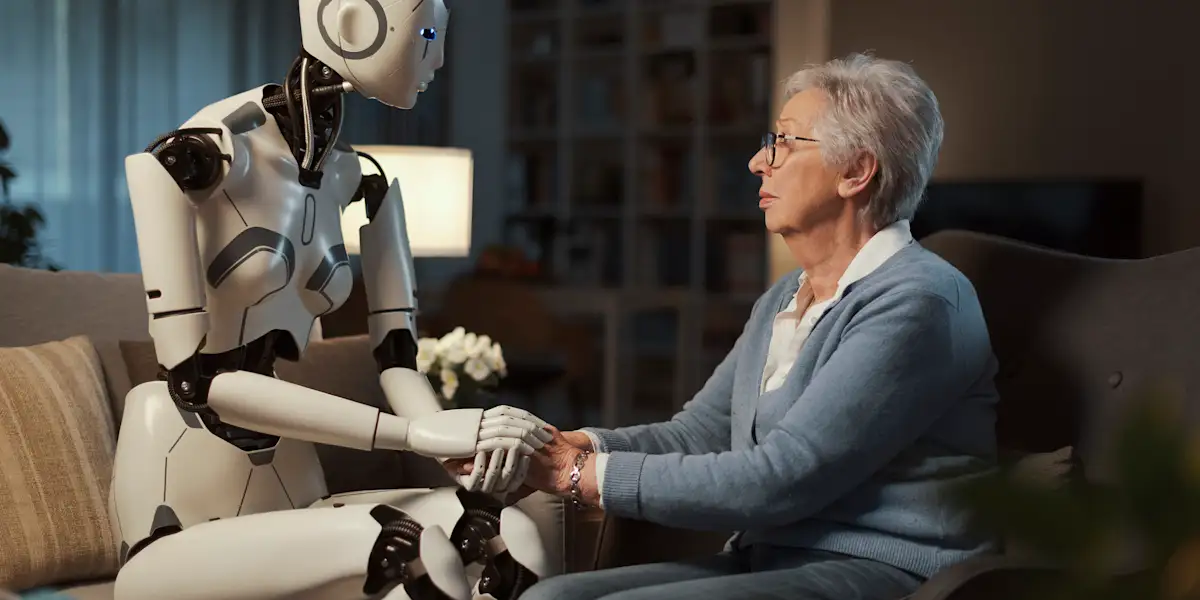

در این نوشتار، به مرور نظرات روانشناسان متخصص دربارهی چرایی استفاده از هوش مصنوعی به عنوان یک تراپیست و نگرانیهای آنها، و همچنین بهترین روشهای جستوجو و کمکگیری از چتباتها در مسایل مربوط به سلامت روان میپردازیم. در آخر، به این پرسش پاسخ میدهیم که چگونه هوش مصنوعی میتواند در آینده به طور امن و مطمئنی جایگزین تراپیستهای انسانی شود!

چگونه مردم از چتباتهای هوش مصنوعی به عنوان درمانگر استفاده میکنند؟

تصور اینکه یک «جلسه تراپی» با هوش مصنوعی، چگونه است؛ کمی چالشبرانگیز به نظر میرسد اما برای اکثر کاربران آنلاین، به سادگی تبادل پیام با یک چتبات است؛ جایی که به افراد اجازه میدهد پرسشهای خاص و اغلب شخصی را بپرسند.

یکی از کاربران تیکتاک که دنبالکنندگان خود را برای استفاده و مکالمه با ChatGPT راهنمایی میکرد؛ میگوید: «به چتبات گفتم باید به عنوان یک تراپیست برای من باشد و در مواقع خاصی که دچار مشکل میشوم و نمیدانم چه باید بکنم؛ به حمایتش نیاز دارم.»

چت جیپیتی پیش از پرسیدن سوالات و ابزار نگرانی سازنده دربارهی وضعیت روحی او یا ارائه راهحلهای ممکن، پاسخ میدهد: «اینجا هستم حمایت کنم و مشاوره بدهم.» همچنین توصیه میکند اگر نگرانیهایش زیاد است یا همچنان آشفته است؛ کمکهای حرفهای دریافت کند.

یکی دیگر از تولیدکنندگان محتوا در تیکتاک، اسکرینشاتهایی از مکالمه خود با چتبات هوش مصنوعی در اسنپچت منتشر کرده است. زمانی که او دربارهی مشکلات یک ارتباط از چتبات سوال میکند؛ چتبات پاسخ داده است: «این قابل درک است که بخواهید بدانید دوست شما چهکار میکند اما مهم است به مرزهای همدیگر احترام بگذارید و اگر این چیزی است که واقعا به آن نیاز دارد؛ به او زمان بدهید.»

در برخی موارد، کاربران با ChatGPT دربارهی افکار خودکشی صحبت کردهاند. دکتر «اولیویا ویلیامز»، استادیار آموزش مشاورههای تراپی در دانشگاه جورجیای غربی و رئیس و بنیانگذار انجمن تراپیستهای علاقهمند به هوش مصنوعی در امریکا میگوید: «حتی در این شرایط، باز هم به نظر میرسد چتباتها میتوانند پاسخهای قابل توجهی به کاربران بدهند.» منظور او، راهنماییهای خوبی است که چتجیپیتی و سایر چتباتها دربارهی خودکشی ارائه میکنند.

او میگوید: «چتباتها، پاسخهای بسیار خوبی میدهند و اغلب مانند یک درمانگر رفتار میکنند و مشاورههای دقیقی به کاربر یا بیمار ارائه میدهند.»

نگرانیها درباره استفاده از چتباتهای هوش مصنوعی به عنوان تراپیست

علیرغم پاسخهای به ظاهر خوب چتباتها به پرسشهای کاربران پیرامون مسایل سلامت روان، تقریبا همه تراپیستها موافق هستند که هنوز هوش مصنوعی یک گزینهی مطمئن برای جایگزینی درمانهای سنتی نیست.

روانشناس «آرنو» توضیح میدهد که در ابتداییترین سطح، نگرانیهایی دربارهی ChatGPT و سایر چتباتها وجود دارد که اطلاعات نادرست یا بیمعنی در پاسخ به سوالات کاربران، ارائه کنند. خود چت جیپیتی به کاربران هشدار میدهد که این فناوری «ممکن است گهگاهی اطلاعات نادرستی ارائه دهد» یا «ممکن است گاهی دستورالعملهای مضر یا محتوای مغرضانه تولید کند.»

روانشناس سرشناس دیگری میگوید برخی نگرانیهای لجستیکی دربارهی استفاده از هوش مصنوعی به عنوان یک تراپیست نیز وجود دارد.

او در ادامه، توضیح میدهد که درمانگرها، آموزش دیده و دارای مجوز فعالیت هستند؛ به این معنی که باید استانداردهای خاصی از تمرین تراپی را رعایت کنند. چتباتهای هوش مصنوعی این استانداردها و دستورالعملها را رعایت نمیکنند:

«هیچ فردی در این فرآیند دخیل نیست. بنابراین، اولین نگرانی که من دارم؛ بحث «مسئولیت» است. کمبود ایمنی در این قضیه وجود دارد که باید درباره آن جدی و صادق باشیم. زیرا اگر مشکلی پیش بیاید؛ چه کسی پاسخگو خواهد بود؟»

این تراپیست به یک نگرانی دیگر هم اشاره میکند و اینکه هوش مصنوعی در نقش یک درمانگر، اطلاعات حساس کاربران را دریافت میکند و خطر انتشار آنها در اینترنت یا لو رفتن این اطلاعات وجود دارد که مستقیما تهدیدی برای حریم خصوصی افراد است.

به طور خاص، سایت چت جی پی تی صراحتا گفته است که همه مکالمات را جمعآوری و ضبط کرده تا از آنها برای آموزش بهتر هوش مصنوعی استفاده کند. البته، کاربران میتوانند انصراف دهند یا حساب کاربری خود را حذف کنند یا مکالمات خود را پاک کنند که مورد آخر، پس از ۳۰ روز از روی سرورهای ChatGPT حذف میشود.

تفسیر اشتباه راهنماییهایی که توسط چتباتها به یک فرد میشود؛ دغدغه بعدی روانشناسها است. چتبات چیزی میگوید اما کاربر پشت صفحهنمایش در آن سوی اینترنت، چیز دیگری برداشت میکند و در درازمدت، میتواند سلامت روانی آن فرد را تحت تاثیر منفی قرار دهد.

با این حال، همهی این تردیدها و نگرانیها را میتوان در یک موضوع اصلی جستوجو کرد؛ اینکه هوش مصنوعی دقیقا همین است: مصنوعی و نمیتواند جایگزین روابط انسانی شود!

«راسل فولمر»، استاد و مدیر مشاوره در دانشگاه هوسون و همبنیانگذار انجمن هوش مصنوعی روانشناسان مشاورهی امریکا میگوید: «من فکر میکنم در آینده احتمالا هوش مصنوعی از بسیاری جهات از تراپیستها پیشی بگیرد اما کاری که نمیتواند انجام دهد؛ این است که انسان باشد. رابطهی درمانی یک عامل واقعا بزرگ و تاثیرگذار در حرفهی تراپیستها است و باعث تغییرات مثبتی در افراد میشود.»

روانشناس «آرنو» توضیح میدهد که درمان سنتی به تراپیست و بیمار اجازه میدهد تا پیوند عاطفی ایجاد کنند و بتوانند اهداف درمان را به درستی ترسیم کنند.

روانشناس «ویلیامز» نیز میگوید: «هوش مصنوعی در جمعآوری دانش در یک حوزهی مشخص، عملکرد بسیار خوبی دارد اما در حال حاضر، این ظرفیت را ندارد که شما را به عنوان یک فرد متمایز از دیگران بشناسد و بداند نیازهای خاص و منحصربهفرد شما چیست.»

آیا چتباتهای هوش مصنوعی میتوانند یک تراپیست امن باشند؟

اگرچه روانشناسان تا حد زیادی همعقیده هستند که استفاده از هوش مصنوعی به عنوان درمانگر، بیخطر نیست اما دربارهی اینکه چه زمانی این فناوری میتواند مفید باشد؛ اختلافنظر دارند.

«آرنو» درباره اینکه روزی فرا برسد که چتباتها به اندازهی کافی پیشرفت کرده باشند تا بتوانند مشاورهای در سطح درمانگرهای انسانی بدهند؛ کمی تردید دارد. دو روانشناس دیگر، «فولمر» و «ویلیامز» معتقدند که چتباتها میتوانند بهعنوان مکمل درمان سنتی به کار روند.

«ویلیامز» میگوید پلتفرمهای گفتوگومحور هوش مصنوعی میتوانند فعالیتی اضافی در کنار تراپی باشند.

او اعتقاد دارد گپ زدن با هوش مصنوعی، میتواند یک فعالیت بیشتر، افزون بر درمان سنتی باشد؛ چیزی مشابه مدیتیشن که روند بهبود را تسریع میکند.

حتی برخی از چتباتهای هوش مصنوعی، مانند Woebot Health و Elomia، بهطور خاص برای اهداف سلامت روان، توسعه داده شدهاند و احتمالا گزینهی بهتری نسبت به چتباتهای عمومی مانند چت جی پی تی هستند. این چتباتها بهطور ویژه میتوانند پاسخهای تخصصی به سوالات حوزهی روان درمانی بدهند.

برای نمونه، چتبات Elomia دارای یک ویژگی است که در صورت نیاز میتواند یک انسان تراپیست را به گفتوگوی مجازی اضافه کند و مشاورههای بهتر و بیشتری ارائه کند. چتبات Woebot نیز براساس دادههای درمانی بالینی آزمایش شده، توسعه یافته است.

«فولمر» میگوید بسیاری از این برنامهها، ضمن اینکه به طور کلی «هوش مصنوعی» هستند؛ هنوز در حال توسعه و پیشرفت و آزمایش بوده و نمیتوان یک نظر قطعی دربارهی قابلیتهای آنها داد یا با تراپیستهای انسانی مقایسه کرد.

میتوان از برآیند همه این صحبتها به این نتیجه رسید که درمانگرهای آنلاینِ هوش مصنوعی، هنوز توانایی یک درمانگر انسانی را ندارند و خیلی زود است که جایگزین آنها شوند اما جامعه به مسایل دیگری توجه دارد که شاید در افکار اساتید روانشناسی دانشگاه، جایگاهی نداشته باشند.

مثلا، دسترسی به تراپیست برای همهی افراد جامعه، به راحتی میسر نیست یا هزینههای جلسات تراپی خیلی گران است و بسیاری از افراد توان پرداخت آن را ندارند. کاربران اینترنتی زیادی هستند که واقعا نیاز به یک درمانگر دارند ولی از ترس هزینههای طولانی مدت آن، ترجیح میدهند به دنبال راهکار یا جایگزین رایگانی باشند.

خود «فولمر» هم این موضوع را تایید میکند و میگوید: «حدس میزنم بین ایدهآلهای من و شناختی که از واقعیت جامعه دارم؛ تفاوتهایی وجود داشته باشد. چتجیپیتی و برخی دیگر از چتباتها، راهحلهای مقیاسپذیری ارائه میکنند که در بسیاری موارد، نسبتا ارزانتر از درمانهای من است. این نکته میتواند یک دلیل خوب برای استقبال از آنها باشد.»

او اضافه میکند اگر حتی فقط یک نفر با هوش مصنوعی به عنوان یک تراپیست، به سلامتی کامل رسیده باشد؛ پس این ایده ارزش بررسی دارد تا به این نتیجه برسیم که کارآمد است یا خیر؟

یک جنبهی مفید دیگر هوش مصنوعی و چتباتها میتواند دستیاری و آموزش تراپیستهای جوان و تازهکار باشد. برخی اوقات، جوانتر نمیتوانند به درستی تصمیم بگیرند کدام استراتژی موثرتر است ولی چتبات در کسری از ثانیه، پیشنهادهای خوبی ارائه میکند.

در حال حاضر، میتوان گفت هیچ جایگزینی برای درمانگرهای انسانی نیست. هوش مصنوعی با دسترسی به حجم زیادی از دادهها و ترکیب آنها با یکدیگر، میتواند اطلاعات مفیدی ارائه کند ولی فقط یک درمانگر انسانی است که میتواند روحیات، خصوصیات و شرایط جسمی و روحی روانی شما را بهطور کامل شناسایی و براساس پاسخهای شما، توصیههای مناسبی ارائه کند.

و بدون شک در آینده، چتباتهای هوش مصنوعی مدعی بزرگی برای از میدان خارج کردن تراپیستهای انسانی هستند و کاربردهای بیشتری در حوزهی سلامت روان خواهند داشت.

دیدگاه خود را بنویسید